无监督聚类最早的思路是关注于算法本身的K⁃means,DBSCAN (Density⁃Based Spatial Clustering of Applications with Noise),而后的聚类研究使用受限玻尔兹曼机[13]、自编码器[14]提取特征.LeNet⁃5[15]的卷积、无监督特征学习卷积神经网络[16]验证了卷积神经网络在无监督学习方面的可行性.深度卷积神经网络拥有强大的图像特征提取能力[17],结合自编码器[14]和深度网络的卷积自编码器[18]提供了全新的图像特征提取方式.生成对抗网络[19]也用于特征提取.深度卷积对抗网络的无监督表示学习[9]证明了其可行性.无监督聚类方法[4]综合使用了聚类和分类来学习视觉特征,在杂乱数据上进行无监督的图像特征预训练方法[20]以及无监督图像分类和分割的不变信息聚类方法[21]上等变换的思路.至此,无监督聚类学习从特征与聚类分步进行发展到联合训练的方向.

尽管这些优秀的深度聚类工作取得了很好的进展,但是随着图像数据类型的多元化,特征表示能力和聚类性能仍有提升空间.因此本文继续探索新的网络和合适的损失函数,提出一种基于新颖卷积自编码器的深度Softmax聚类算法(Asymmetric Convolutional Auto⁃encoder Based Softmax Clustering,ASCAE⁃Softmax).本文的主要贡献如下:

(1)采用新的卷积形式,通过首个卷积核与步长相等实现图像的分割式特征提取,进一步提高了特征的鲁棒性.

(2)提出一种非对称的卷积自编码器结构,通过编码器和译码器的信息不对等使得所学特征更专注于特征的分解和生成.

(3)利用Softmax分类的思路解决聚类问题,将所学到的特征通过高斯方式映射成条件概率,并获得所有数据在同一类别上的概率分布.减小同类间隔,增大异类之间的间隔.不断优化该网络的特征表示,提高了聚类精度.

1 相关工作

以往的无监督聚类算法在特征的提取与聚类操作上相互独立,如何将深度卷积网络提取特征的训练与聚类过程联合在一起成为无监督聚类学习的重要方向.2016年,Xie et al[8]以卷积自编码器为基础,在生成特征的层面上做了新的改进,首次找到联合解决特征空间学习与聚类关系判别的方案DEC(Unsupervised Deep Embedding for Clustering Analysis)算法.通过深度自编码器初始化数据到特征的映射,使用K⁃means生成特征的聚类中心点.使用t⁃分布[22]衡量特征点与特征聚类中心点的相似性,通过软分配方式生成每个数据的聚类概率分布,构造辅助目标分布,使用KL(Kullback⁃Leibler)散度损失进行优化以细化聚类中心点,同时对生成特征的网络参数进行不断调整来优化聚类结果,直至网络收敛.其最终的聚类结果的精度超越了以往的聚类方法,更是无监督学习的一大进步,因为特征的学习与聚类的判别不再是相互独立的,而是可以联合在一起进行训练和优化.但其使用的深度自编码器在特征的提取上仍有局限性.

为了优化这个问题,2017年,联合卷积自动编码器嵌入和相对熵进行深度聚类方法(Deep Clustering via Joint Convolutional Autoencoder Embedding and Relative Entropy Minimization,DEPICT)[5]在对原始的无监督深度嵌入聚类算法整体思路不变的情况下使用多项逻辑回归函数计算特征点与聚类中心点的相似性;同时将网络修改为深度卷积去噪自编码器;输入数据方使用不包含噪声的输入数据生成辅助目标分布来优化带有噪声的输入数据的聚类概率分布.2018年全卷积自编码器的判别增强图像聚类方法(Discriminatively boosted clustering,DBC)[6]将深度自编码器优化为深度卷积自编码器,通过判别式增强分配的方式提高聚类分配的纯度.在其他方面不变的情况下,得到了更优的结果.

2 深度嵌入Softmax聚类算法

2.1 非对称卷积特征(ASCAE)提取器

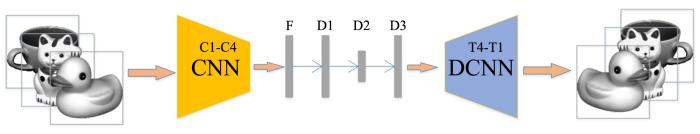

与传统的深度卷积自编码器网络相比,本文的网络添加多个不同数量神经元的全连接层,将整个网络修改为非对称的结构,整个网络结构如图1所示.

图1

图1

非对称的卷积自编码网络(ASCAE)框架图

Fig.1

A framework of the Asymmetric Convolutional Auto⁃encoder (ASCAE) network

其中,编码器包括卷积层C1⁃C4和全连接层F层、D1和D2,而且F层为C4的特征图变成的特征向量.解码器包括全连接层D2和D3和反卷积层T4⁃T1,而且D3层的神经元个数与F层的相同.F层、D1层、D3层为50个神经元,D2层的神经元个数为类别个数左右.由于D2层包含的神经元个数较少,信息量被大大地压缩,所以本文均使用F层的特征为输入图像的特征表示.

表1 ASCAE网络参数设置

Table 1

| Layers | Kernel | Strides |

|---|---|---|

| C1 | 3 | |

| C2 | 2 | |

| C3 | 2 | |

| C4 | 1 | |

| F | 50 | - |

| D1 | 50 | - |

| D2 | K | - |

| D3 | 50 | - |

所有待聚类的图片均变换为

其中,

在训练好的ASCAE网络上,用F层的输出作为特征信息,且保留C1⁃F层的网络结构和网络权重进行无监督深度嵌入聚类算法.

2.2 深度聚类Softmax算法(ASCAE⁃Softmax)已知含有

在ASCAE网络后接一个带参数的Softmax分类器,对特征集

其中,

为了进一步减小同类的间隔,增大异类的间隔,先用同一类中数据的概率除以该类所有数据概率的总和即软聚类频率,接着重新计算每个数据属于不同类别的概率分布.即对分类概率矩阵

此时,特征属于类别的概率之和不为1,继续对其进行行向量归一化:

得到辅助概率分布

该深度嵌入Softmax聚类方法的目标函数为:

其中,第一项是KL散度描述这两个概率分布的差异性.第二项是网络参数的L2正则项能稀疏化网络,提高网络的泛化能力,避免网络权值的爆炸式变化.

用随机梯度下降法更新网络参数和Softmax分类参数为:

根据

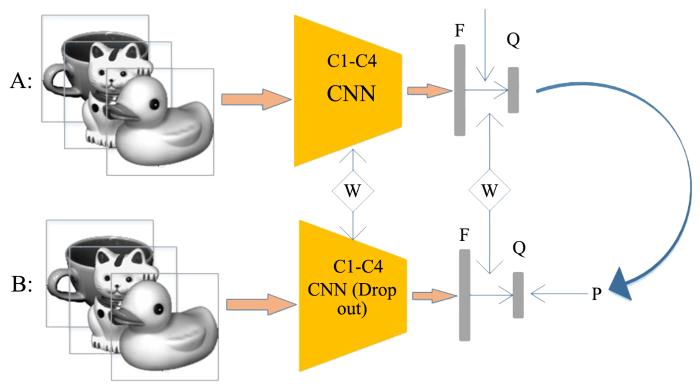

图2

3 实验与分析

本文在六个经典的图像数据集上进行实验,评价聚类性能的数值指标包括聚类精度(Accuracy,ACC)和标准互信息(Normalized Mutual Information,NMI).ACC表示聚类结果的正确率,而NMI衡量了预测分布与真实分布的相关程度.两个指标值越接近1,说明聚类准确度越高.实验环境为Intel Corei5⁃6300HQ处理器,NVIDIA 2.0 GB显存,8.0 GB RAM内存;基于TensorFlow2.0搭建网络.

3.1 MNIST数据集

在经典的手写数字集MNIST上,设D2层的神经元个数等于类别数10,用算法1端到端训练ASCAE直至收敛.对F层的特征进行K⁃means聚类分析(重复50次,取最好的聚类性能),取编码器F层及其左半部分,生成Softmax的聚类网络结构(如图2所示),用算法2优化ASCAE权值和Softmax参数W,直至满足停止条件.

输入:图像数据集、类簇个数

输出:网络权值、特征表示;类中心和聚类指派

①使用端到端策略训练ASCAE,对目标函数(1)用随机梯度下降的算法最小化迭代直到收敛;

②输出网络参数值和F层的特征表示;

③K⁃means算法对特征进行聚类,得到聚类中心和聚类指派.

输入:编码器的参数值和特征表示

输出:类标向量和类簇中心

联合训练过程:

①根据

② 根据

③根据

④对于每一个数据取概率分布最大值位置为所属类簇.

表2 在MNIST数据集上比较ASCAE,ASCAE⁃Softmax和六个聚类算法的聚类性能

Table 2

其中,KMS算法是经典K⁃means算法直接对原始图像进行聚类;AEC(Auto⁃encoder Based Data Clustering)算法是先用深度自编码器提取特征,然后用K⁃means聚类,而训练深度自编码器的目标函数由数据重构误差和紧致性两部分组成;IEC(Infinite Ensemble For Image Clustering)算法包含深度表示学习和聚类融合;DEC,DBC,DEPICT算法均为同时学习特征表示和聚类中心,采用深度自编码器学习特征表示和软K⁃means聚类,其中DEC,DEPICT为参考源代码的复现,得到与原论文相近的实验结果,DBC在没有源代码可参考的情况下尽可能地复现所有提到的细节,但结果不尽人意,可能是没抓到某些训练小细节,导致实验出现了一些偏差.

K⁃means聚类)稍差,但都优于另外六个算法.且在与其他深度聚类算法相比较时,其他算法注重联合训练的优化,本文不仅对联合训练进行了优化,还对自编码器进行了大量的优化,进一步提高了联合训练时的下限,在初次联合训练时就能得到更好的概率分布.此外,KMS的聚类性能最差,说明以像素为特征时,很难区分同类图像的相似和异类之间的差异.

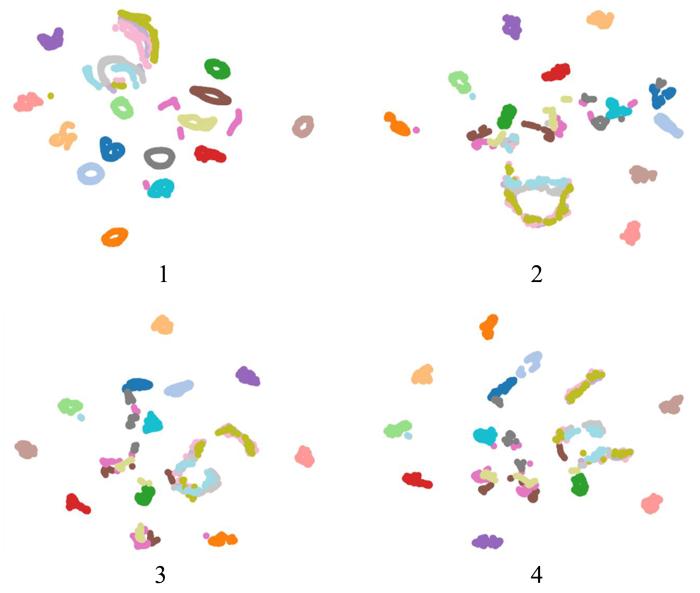

图3

图4

图4

MNIST上ASCAE⁃Softmax的F层特征

Fig.4

F⁃layer features of ASCAE⁃Softmax on MNIST dataset

3.2 COIL⁃20物品数据集

图5

表3 ASCAE,ASCAE⁃Softmax和六个聚类算法在COIL⁃20上的聚类性能

Table 3

根据表3可知,联合训练的ASCAE⁃Softmax和ASCAE和DEN相比,聚类精度提高了1.5%和3.0%,KMS仍是最差.在相同的实验环境下,与DEC,DBC,DEPICT相比亦在聚类精度上获得了些许提升,很大程度上说明了初始聚类概率分布对于最终结果的影响.虽然ACC精度优于其他六个算法,但NMI不及DEN算法.而且在实验中发现,较小的数据量不利于获取辅助目标的概率分布,使优化聚类特征较为困难.当自编码器提取出优异的特征,提供了较高的聚类精度,后续的联合优化能有限地提升聚类精度.

图6展示了COIL⁃20数据集在深度嵌入聚类算法的过程可视化.可以看出不同类别特征之间的距离逐渐增大,相同类别的特征逐渐变得紧凑.特征空间是逐渐向同类紧凑、异类稀疏的方向发展.

图6

图6

COIL⁃20上ASCAE⁃Softmax聚类过程的可视化

Fig.6

Visualization of ASCAE⁃Softmax clustering process on COIL⁃20 dataset

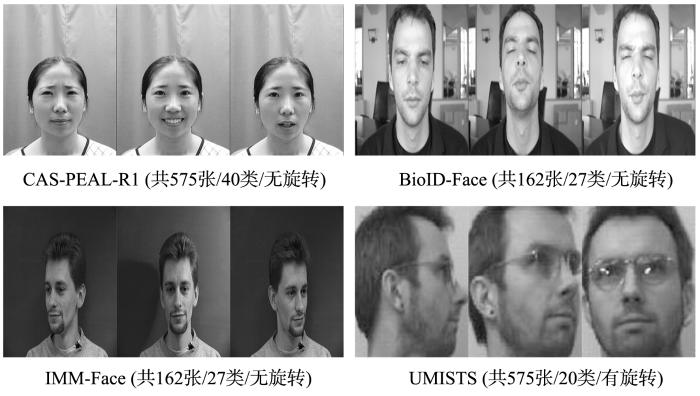

3.3 人脸数据集

在四个形态、角度各异的人脸图像集(CAS⁃PEAL⁃R1((http:∥www.jdl.ac.cn/peal/index.html),BioID⁃Face(https:∥www.bioid.com/About/BioID⁃Face⁃Database),IMM⁃Face(http:∥www.imm.dtu.dk/~aam/aamexplorer/),UMIST(https:∥blog.csdn.net/garfielder007/article/details/51480770)上进行了第三组实验,数据集的差异性如图7所示.先将人脸图像缩小为

图7

表4 ASCAE和ASCAE⁃Softmax算法在四个人脸图像集上的聚类性能

Table 4

| ASCAE | ASCAE⁃Softmax | |||

|---|---|---|---|---|

| ACC | NMI | ACC | NMI | |

| CAS⁃PEAL⁃R1 | 0.890 | 0.958 | 0.900 | 0.959 |

| BioID⁃Face | 0.852 | 0.949 | 0.895 | 0.950 |

| IMM⁃Face | 0.550 | 0.760 | 0.571 | 0.763 |

| UMISTS | 0.442 | 0.647 | 0.447 | 0.654 |

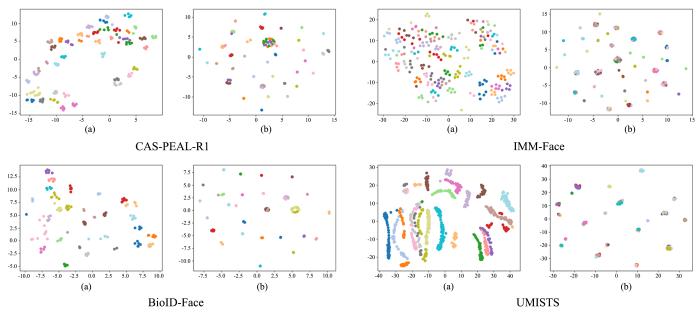

图8

图8

四个人脸数据集上ASCAE和ASCAE⁃Softmax的F特征可视化

Fig.8

Visualization of F features: (a)ASCAE,(b) ASCAE⁃Softmax on the four face datasets

从表4可以看出,在无旋转的人脸数据集CAS⁃PEAL⁃R1和BioID⁃Face上可以获得较好的实验结果,但是在有旋转角度的IMM⁃Face,UMISTS上,得到与 MNIST和COIL⁃20上相同的结论.即有旋转角度时,聚类精度较差;无角度的数据上有很高的聚类精度.结合了Softmax的联合训练虽然对于精度的提升不是很大,但在特征的可视化方面贡献突出,表现为特征在同类上更为紧凑,在异类上更为稀疏,从而类别间更易划分.

4 结 论

本文提出一种基于非对称卷积自编码器的特征提取器.用卷积核大小与步长相同的卷积方式在传统的卷积编码器上加了多个全连接层,且全连接层的神经元个数不一,整个网络呈非对称结构.在获取聚类特征后,采用深度Softmax聚类方法.用Softmax函数计算每个数据点的聚类概率分布,使用不含Dropout的网络获取构造辅助目标分布,优化有Dropout层的网络.不断优化特征得到了更优的聚类概率分布和特征生成空间.

实验表明,本文提出的基于非对称卷积编码器的深度Softmax聚类算法在没有角度的图像集上有很好的结果,优于其他深度聚类算法.在有旋转的图像上,聚类精度不是特别突出但仍能优于部分深度聚类算法.在本文的六个图像集生成的特征空间上,拥有同类紧凑异类稀疏的独特优势.因此本文的方法是行之有效的图像深度聚类方法之一.

显然,图像类型的多样性带来更多的不确定性,增加了图像级别知识颗粒的不可分辨性.如何有效地进行图像聚类分析将是下一步的研究内容.

参考文献

AED:unsupervised representation learning by auto⁃encoding transformations rather than data

∥

Contrastive adaptation network for unsupervised domain adaptation

∥

Unsupervised feature learning via non⁃parametric instance discrimination

∥

Deep clustering for unsupervised learning of visual features

∥

Deep clustering via joint convolutional autoencoder embedding and relative entropy minimization

∥

Discriminatively boosted image clustering with fully convolutional

auto⁃encoders

Joint unsupervised learning of deep representations and image clusters

∥

Unsupervised deep embedding for clustering analysis

arXiv:1511

.

Learning unsupervised video object segmentation through visual attention

∥

Unsupervised image matching and object discovery as optimization

∥

An introduction to restricted Boltzmann machines

∥Alvarez L,Mejail M,Gomez L,

Learning representations by back⁃propagating errors

Gradient⁃based learning applied to document recognition

Discriminative unsupervised feature learning with convolutional neural networks

∥

Reducing the dimensionality of data with neural networks

Stacked convolutional auto⁃encoders for hierarchical feature extraction

∥

Generative adversarial nets

∥

Unsupervised pre⁃training of image features on non⁃curated data

∥

Invariant information clustering for unsupervised image classification and segmentation

∥

Visualizing data using t⁃SNE

Striving for simplicity:the all convolutional net

arXiv:1412

.