织物瑕疵检测在纺织工业生产过程中有至关重要的作用,随着产业链升级,生产线产生的瑕疵类型越来越多,缺陷和背景纹理的区分度也越来越低,需要泛化能力更强的算法,在复杂多变的检测环境下仍能保持稳定的精度.已有的织物瑕疵呈多态性,主要分污渍类瑕疵和破损类瑕疵.污渍类瑕疵与背景纹理在颜色空间上有明显区别,但过度关注颜色特征会导致高梯度纹理区域的误判.破损类瑕疵和背景纹理存在高度内在相似性,有时会相互穿插而导致边缘预测不够准确,这一直都是该类瑕疵的检测难点.

1 相关工作

Liu et al[6]提出一种多阶段GAN(Generative Adversarial Networks)框架来应对迭代快速的新型面料:第一阶段,GAN在新的无缺陷样品中生成合理的瑕疵来更新数据集,在此基础上改进语义分割网络完成第二阶段的织物瑕疵检测任务.Chen et al[7]提出基于遗传算法的Gabor Faster R⁃CNN用于显著性织物瑕疵检测,能较好地减少纹理干扰,但对于复杂纹理中的低显著性瑕疵检测,效果不理想.Jing et al[8]将Mobile⁃Unet用于织物瑕疵检测来解决实际工业中不同种类瑕疵因数量差异导致的数据不平衡问题,但容易对梯度较大的无瑕纹理区域产生误判.现有的深度学习方法针对复杂纹理织物中的不规则瑕疵依然存在边缘检测模糊和纹理区域错检问题.

现有的织物瑕疵检测算法通常借助预训练好的模型(如VGG⁃16[9],ResNet⁃18 (34,50,101)[10],Dense⁃169[11]等)作为骨干网络来提高模型的收敛速度和检测精度.近年的研究表明[12-14],多尺度信息可以更好地提取不同尺寸瑕疵的特征,有助于提高瑕疵检测的精度.自注意力机制具有较强的全局建模能力,Transformer[15]被广泛应用在计算机视觉领域中.Dosovitskiy et al[16]提出vision Transformer,在各大目标检测数据集上取得了不错的效果.Liu et al[17]提出基于转换窗口的Swin Transformer,在COCO数据集上的检测效果十分优异.Tian et al[18]串联Swin Transformer和特征金字塔,搭建双向对象⁃上下文优先排序模型,将Swin Transformer作为检测任务的骨干网络.

许多研究者更关注特征融合方式的效能.Lin et al[19]构造了一种自顶向下、带有横向连接的特征金字塔来构建多个尺度的深层语义特征.Hou et al[20]提出DSSNet,对深层的输出先上采样,然后拼接浅层的输入,以短连接的方式集成多层次特征.Zhao et al[21]在PSPNet中设计了Pyramid Pooling Module,聚合不同区域的上下文信息来提高网络获取全局信息的能力.上述方法采用单分支骨干网络,通过添加深层模块捕获全局特征.但在深层网络中,局部特征冗余容易引起瑕疵边缘的错误预测,全局特征稀疏容易引起背景区域的错检.在面对复杂纹理样本时,由于解码块不能很好地从特征图中筛选出瑕疵,很容易对高梯度纹理区域判断错误,使误检率升高.

以上大部分改进损失函数的方法都采用外部加权的方式,目的都是增加错误预测像素损失值的贡献,引导模型沿正确方向迭代.值得注意的是,若过度地增大错误预测像素的损失贡献,容易混淆瑕疵和背景交界区域,进而陷入局部最优,导致高梯度纹理区域的错检.

为了解决上述问题,本文提出融合双路多尺度信息的网络模型(WNet)用于复杂纹理织物的瑕疵检测.为了提高训练速度,采用预训练的ResNet⁃18 (RBlock⁃0~4)作为骨干网络左分支.为了降低深层网络中背景特征对瑕疵特征的干扰,采用预训练的Swin Transformer (STBlock⁃1~4)作为骨干网络右分支,借助自注意力机制出色的全局建模能力在卷积深层网络中补充全局上下文信息.为了减少深层网络中瑕疵细节信息丢失,提出一种轻量级双分支池化金字塔(Dual⁃Branch Pooling Pyramid,DBPP)将浅层多尺度细节特征引入深层模块.特征融合阶段,在双分支池化金字塔的基础上设计新的特征融合模块,即多尺度嵌套双分支模块(Multiscale Dual⁃Branch Nested Module,DBN).最后,为了降低高梯度纹理区域的误检率,对二元交叉熵损失函数进行改进来提高最终的检测精度.

本文的主要创新:

(1)提出一种双端输入型网络框架WNet,用两个预训练的骨干网络分别提取多尺度局部和全局特征.提出由DBPP,RBlock⁃0及其相应特征融合模块构成的瑕疵特征增强器,将低级多尺度细节特征导入最终的特征融合模块,降低瑕疵细节信息损失,提高瑕疵边缘预测的准确性.RBlock⁃1~4,STBlock⁃1~4及其对应的特征融合模块组成纹理特征过滤器,在卷积深层网络中补充全局上下文信息,为特征融合模块提供更丰富的纹理特征信息,有利于特征融合模块对高梯度纹理特征中的瑕疵特征进行甄别.最后,将全部尺度特征融合器输出的特征图融合,获得预测图像.

(2)为了减少深层网络中瑕疵细节信息的缺失,提出一种轻量化双分支池化金字塔,以较少的计算消耗在深层网络中引入多尺度低级细节特征.在特征融合阶段,为了进一步提炼、甄别、增强输入特征,筛选高梯度纹理特征及瑕疵特征,通过嵌套DBPP构建特征融合器DBN.每一尺度的特征融合模块都融合多个感受野范围内的信息,为最终的输出融合模块补充更全面的上下文信息.

(3)用改进二元交叉熵损失函数WGBCE Loss进行深度监督,在四个瑕疵数据集上进行综合评估,并与其他最先进的方法进行比较.WNet在所有测试数据集上的综合评价指标均较优,尤其是fmeasure、阳性预测率和阴性预测率较高.

2 融合双路多尺度信息的织物瑕疵检测方法

以预训练的骨干网络作为编码器能极大地提高模型的收敛速度和检测精度,但低尺度特征提取模块信息来源单一,下采样过程中细节信息的丢失会影响深层全局上下文信息的提取,在网络深层模块中会出现局部特征冗余和全局特征稀疏的问题,大大影响瑕疵边缘的预测精准度以及高梯度纹理区域的判断.因此,本文提出一种融合双路多尺度信息的织物瑕疵检测方法WNet.

2.1 WNet模型架构

本文提出一种网络架构思想:以n个不同骨干网络作为支撑,使用一个特征融合器对多种不同空间内的特征信息进行融合、筛选.依赖多阶段的损失函数对不同阶段给予不同的损失权重和计算方式,引导各阶段的迭代趋向.理论上可以根据任务类型设置n个骨干分支来实现多端输入,但是具有多骨干分支的架构过于复杂,对特征融合器的过滤能力要求较高,还会带来高昂的计算开销.因此,针对织物瑕疵检测,本文采用双端输入的网络模型WNet.

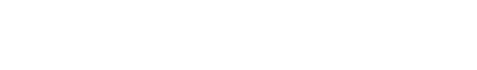

WNet由瑕疵特征增强器和背景特征过滤器构成(图1).DBPP,RBlock⁃0及其相应特征融合模块组成瑕疵特征增强器.卷积浅层网络中蕴含丰富的细节特征,将原始多尺度细节特征引入最后的特征融合模块来减少瑕疵细节信息的损失,提高瑕疵边缘预测精度.消融实验去除DBPP的fmeasure降低了0.95%,RBlock⁃1~4,STBlock⁃1~4及其对应的特征融合模块组成背景特征过滤器.在卷积深层网络中补充全局上下文信息可以为特征融合模块提供更丰富的纹理特征信息,有利于特征融合模块对高梯度纹理特征中的瑕疵特征进行筛选.消融实验中不使用ST骨干分支,检测精度降低了6.67%.在特征融合阶段,各级模块在损失函数引导下生成各个阶段的输出特征图.所有特征图首先上采样至原始分辨率,然后进行最终融合,生成最终的预测图像.

图1

为了以较低的计算成本捕获多尺度不同感受野的特征信息,本文设计了轻量化的DBPP,在此基础上搭建DBN.DBN作为特征融合模块能较好地筛选瑕疵特征,2.2将详细介绍模块构成.瑕疵特征增强器的两个输出特征图和背景特征过滤器的四个输出特征图首先被采样至输入图像分辨率,再经过融合模块生成预测图像.

为了提高预测置信度,将高斯概率分布权重WG 赋予二元交叉熵损失函(BCE Loss),提高瑕疵检测精度.在消融实验中,使用WGBCE Loss的fmeasure比标准BCE Loss提高0.79%.假设

其中,DBN( )0为0级嵌套双分支模块,

2.2 双分支嵌入特征融合模块

2.2.1 双分支池化金字塔

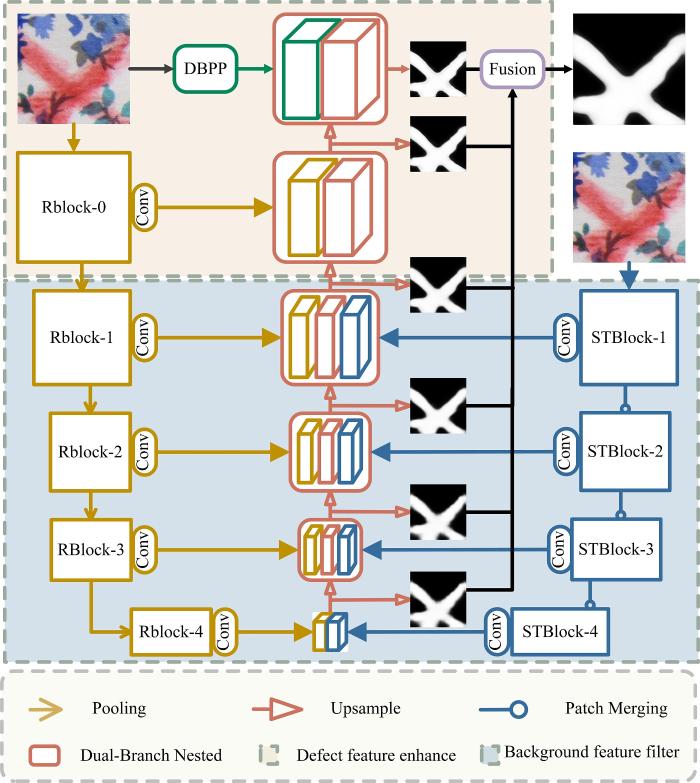

浅层高分辨率特征图保留了瑕疵的边缘、形状、大小等丰富的局部信息,而局部特征提取的充分性决定了预测图的细节呈现,进而决定检测精度的上限.若特征提取模块太关注局部信息,忽略全局信息,容易引发纹理像素点及区域的误判,可以通过大核卷积堆积或者扩张卷积的方式关注全局信息.如图2所示,假设原始特征图的高为H,宽为W,中心像素点

图2

图2

DBPP模块与ASPP模块以及卷积堆叠的对比

Fig.2

Comparison of DBPP module with ASPP module and convolutional stacking

如图2a所示,普通的卷积层堆叠方式,需要不断地堆叠层数,渐进式地学习全局上下文信息,如

使用ASPP中的多倍率池化卷积方式,如图2b所示,以最大倍率为

其中,D表示卷积空洞倍率.为了加强不同空洞倍率感受野内特征信息的交互性,往往需要增加多个不同倍率的空洞卷积层.但由于高倍率空洞卷积要保证输出特征图的尺寸与原始特征图相同,边界处的卷积操作添加了过多填充,这不仅引入了过多的噪声,而且提升了该模块的参数量.

为解决上述问题,本文提出双分支池化金字塔DBPP.如图2c所示,通过池化融合邻域内四个像素的特征信息,同时降低特征图大小.这种操作可以极大地降低模型运算量,双分支分别采用3×3卷积和3×3dilation=2卷积,保证感受野范围均匀扩大.对每一幅原始特征图

中心特征与边缘特征建立联系仅需要搭建

2.2.2 嵌套双分支模块

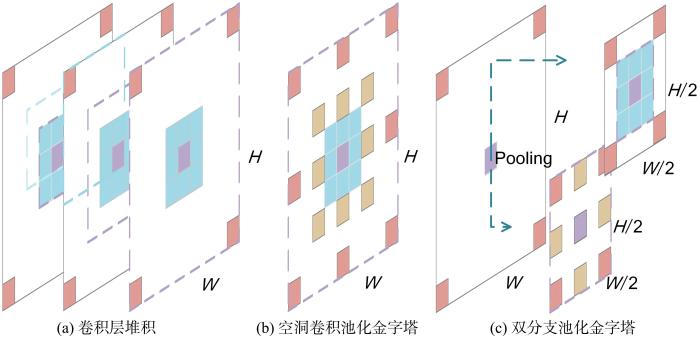

通过嵌套DBPP实现的多尺度嵌套双分支模块(DBN)如图3所示,主要用于解码阶段的特征融合,也用于浅层高分辨率特征图的细节特征提取.

图3

DBN的形状类似二叉树,是编解码结构的特征提取模块.两个特征提取分支关注不同感受野中的局部信息,可对原始特征图的局部信息进行交叉验证.通过与原始分支的融合,类似给原始特征图赋予空间注意力机制,起瑕疵增强的作用.最后一个融合输出加在原第一层卷积层上,求出当前模块输出.假设

其中,f代表Conv,

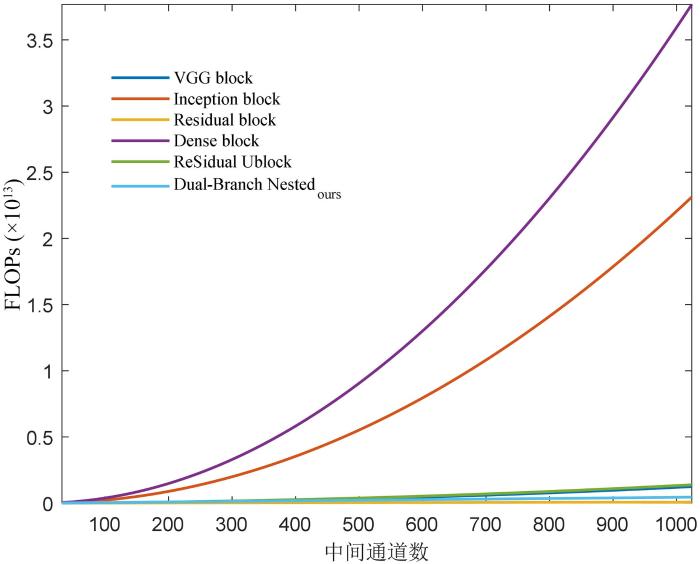

多尺度嵌套双分支模块的编码层深度

图4

图4

不同模块随中间通道数变化的FLOPs

Fig.4

The FLOPs of different modules changing with the number of intermediate channels

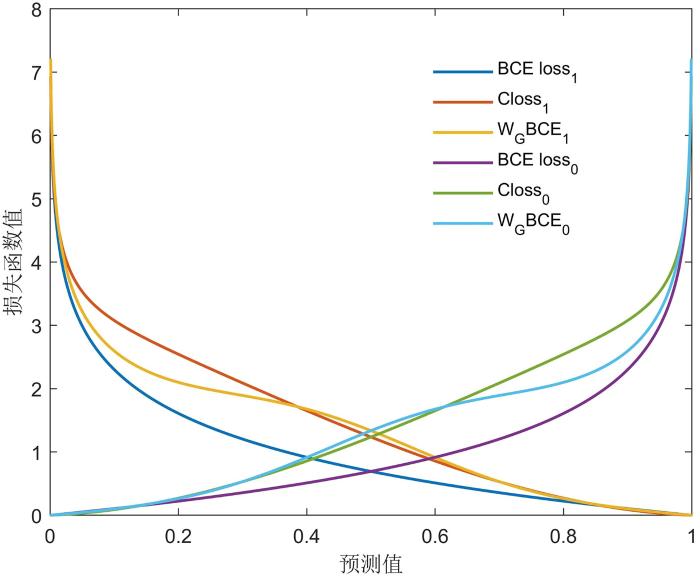

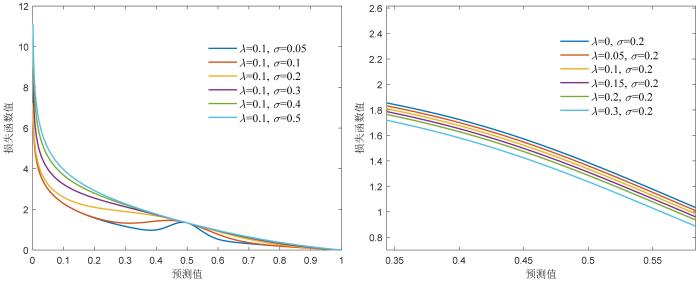

2.3 改进二元交叉熵损失函数

置信度偏低的预测在织物瑕疵检测任务中十分常见,特別是在瑕疵与高梯度纹理的交界处.损失函数的目的是缩小预测值和实际值之间的差异,即提高预测置信度.损失函数可以总结为:

其中,

针对上述问题,本文在标准二元交叉熵损失函数的基础上进行改进,通过高斯概率分布权重WG 赋予偏离Ground Truth的预测更大的损失贡献.为了减少假阳性和假阴性预测,利用F误差平滑损失函数曲线,使显著性预测图更偏向真阳性和真阴性预测.损失函数的定义如下:

其中,

图5

图5

WGBCE Loss与其他损失函数的可视化比较

Fig.5

Visual comparison of WGBCE loss with other loss functions

由图可见,预测值趋近标签值的范围在

3 实验与结果分析

实验配置:PyTorch 1.9.1,cuda 11.0,Python 3.7,基于PyTorch深度学习框架构建网络模型;处理器为CPU 5600x @ 4.6 GHz,GPU NVIDIA 3060 ti,显存8 G,内存16 G.五个DBPP的中间通道数为

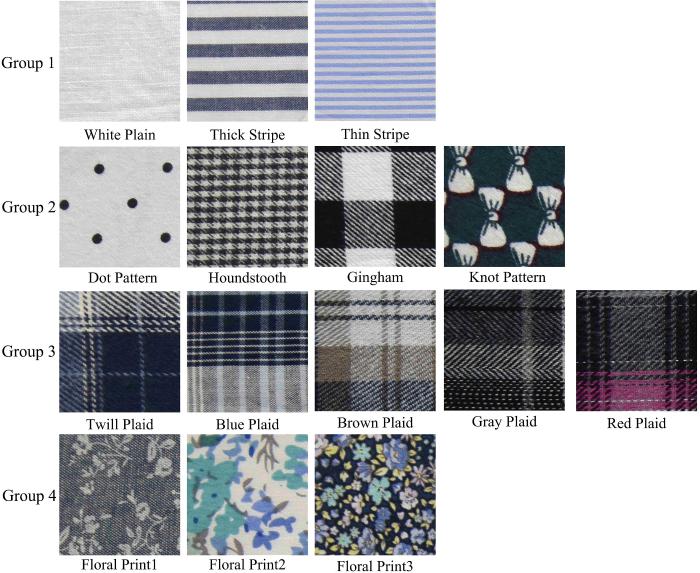

3.1 数据集

使用浙江大学构建的织物瑕疵数据集ZJU⁃Leaper[30],它由19种不同纹理类型的98777张织物图组成,带有详细的注释.选用前15种复杂纹理织物的18855张瑕疵样本,图6展示了15种织物样本的图片.织物样本按纹理复杂度被分为四个组,命名为Group 1~4.第一组包含White Plain,Thick Stripe,Thin Stripe;第二组包含Dot Pattern,Houndstooth,Gingham,Knot Pattern;第三组包含Twill Plaid,Blue Plaid,Brown Plaid,Gray Plaid,Red Plaid;第四组包含Floral Print1,Floral Print2,Floral Print3.为了提高训练速度,将图像尺寸压缩至256×256构成新的数据集,按9∶1的比例将数据样本分为训练集和测试集.实验中,输入图像首先缩放至320×320,然后随机裁切为224×224,再随机经过旋转、镜像、翻转操作进行图像增强.

图6

图6

ZJU⁃Leaper数据集中四组织物15种背景纹理的示例图像

Fig.6

Example images for 15 patterns of four groups of ZJU⁃Leaper dataset

3.2 评价指标

使用fmeasure[31]进行评价:

具体的几个指标:Precision为查准率,即阳性预测率(Positive Predictive Value,PPV);Recall为查全率,即真阳性率(True Positive Rate,TPR);假阳性率(False Positive Rate,FPR),即误检率;阴性预测率(Negative Predictive Value,NPV).另外,依据参考文献[3],将

显然,fmeasure综合考量了TPR和PPV.fmeasure,TPR,PPV,NPV越高,FPR越低,说明该方法的瑕疵检测性能越好.为了综合评估本文的模型并排除低置信预测的影响,添加另外三个指标,分别为MAE,PR曲线和ROC曲线.

MAE:预测值和Ground Truth像素差值的绝对值之差的平均值,定义为:

MAE越小,说明预测值与真值偏差越小.

PR曲线:给定一个预测的概率图,通过0~255之间的不同阈值进行二值掩码,并与Ground Truth进行比较,计算Precision和Recall,可以绘制PR曲线.

ROC曲线:纵轴是TPR,横轴是FPR,当数据集中的阳性和阴性样本分布不均时,ROC曲线比PR曲线更能保持稳定.

3.3 定量比较

表1 本文算法和对比方法在ZJU⁃Group 1上的定量实验结果的比较

Table 1

| 方法 | f | TPR | FPR | PPV | NPV | MAE | Time (ms) |

|---|---|---|---|---|---|---|---|

| PicaNet (Group) | 75.62% | 77.89% | 2.28% | 73.48% | 98.12% | 0.020 | 99 |

| PicaNet (Total) | 65.56% | 67.85% | 2.66% | 63.43% | 97.30% | 0.004 | 99 |

| F3Net (Group) | 76.92% | 82.92% | 2.38% | 71.72% | 98.17% | 0.032 | 23 |

| F3Net (Total) | 74.93% | 79.32% | 2.11% | 71.00% | 97.83% | 0.098 | 23 |

| U2Net (Group) | 76.01% | 78.77% | 2.21% | 73.43% | 98.13% | 0.016 | 27 |

| U2Net (Total) | 73.78% | 77.18% | 2.43% | 70.67% | 97.69% | 0.010 | 27 |

| GCPANet (Group) | 76.80% | 82.75% | 2.61% | 71.64% | 97.93% | 0.150 | 20 |

| GCPANet (Total) | 76.30% | 81.51% | 2.24% | 71.72% | 97.73% | 0.125 | 20 |

| SCWS (Group) | 72.90% | 79.05% | 8.08% | 67.64% | 93.10% | 0.080 | 22 |

| SCWS (Total) | 74.12% | 82.15% | 7.01% | 67.51% | 96.45% | 0.069 | 22 |

| DDNet (Group) | 76.87% | 81.08% | 2.55% | 73.07% | 98.09% | 0.014 | 20 |

| DDNet (Total) | 74.18% | 77.89% | 3.14% | 70.81% | 97.88% | 0.012 | 20 |

| RCSB (Group) | 74.85% | 76.43% | 1.82% | 73.34% | 98.07% | 0.015 | 76 |

| RCSB (Total) | 72.28% | 77.41% | 8.74% | 67.78% | 96.38% | 0.065 | 76 |

| WNet (Group) (Ours) | 78.08% | 80.66% | 2.19% | 75.67% | 98.61% | 0.016 | 25 |

| WNet (Total) | 75.77% | 80.65% | 2.61% | 71.43% | 98.33% | 0.014 | 25 |

表2 本文算法和对比方法在ZJU⁃Group 2上的定量实验结果的比较

Table 2

| 方法 | f | TPR | FPR | PPV | NPV | MAE | Time (ms) |

|---|---|---|---|---|---|---|---|

| PicaNet (Group) | 67.48% | 73.46% | 4.16% | 62.40% | 98.02% | 0.012 | 95 |

| PicaNet (Total) | 65.48% | 68.42% | 2.88% | 62.77% | 96.93% | 0.007 | 95 |

| F3Net (Group) | 76.36% | 82.15% | 2.42% | 71.34% | 98.11% | 0.128 | 19 |

| F3Net (Total) | 73.76% | 78.74% | 2.55% | 69.37% | 98.00% | 0.146 | 19 |

| U2Net (Group) | 73.34% | 77.69% | 2.80% | 69.46% | 98.11% | 0.014 | 25 |

| U2Net (Total) | 70.34% | 74.70% | 3.01% | 66.46% | 97.73% | 0.013 | 25 |

| GCPANet (Group) | 74.38% | 80.32% | 3.11% | 69.26% | 97.13% | 0.196 | 20 |

| GCPANet (Total) | 75.19% | 80.69% | 2.62% | 70.40% | 97.35% | 0.171 | 20 |

| SCWS (Group) | 69.83% | 77.29% | 9.32% | 63.68% | 93.51% | 0.090 | 20 |

| SCWS (Total) | 69.02% | 82.64% | 11.50% | 59.25% | 92.21% | 0.113 | 20 |

| DDNet (Group) | 74.54% | 78.72% | 2.96% | 70.78% | 98.17% | 0.015 | 18 |

| DDNet (Total) | 74.29% | 78.74% | 4.31% | 70.33% | 98.05% | 0.017 | 18 |

| RCSB (Group) | 72.03% | 79.55% | 5.41% | 65.80% | 98.81% | 0.012 | 73 |

| RCSB (Total) | 71.76% | 76.24% | 5.30% | 67.78% | 97.73% | 0.035 | 73 |

| WNet (Group) (Ours) | 76.66% | 79.34% | 2.29% | 74.16% | 98.45% | 0.013 | 24 |

| WNet (Total) | 74.64% | 78.30% | 2.47% | 71.30% | 98.30% | 0.014 | 24 |

表3 本文算法和对比方法在ZJU⁃Group 3上的定量实验结果的比较

Table 3

| 方法 | f | TPR | FPR | PPV | NPV | MAE | Time (ms) |

|---|---|---|---|---|---|---|---|

| PicaNet (Group) | 63.72% | 67.91% | 2.63% | 60.02% | 98.23% | 0.021 | 95 |

| PicaNet (Total) | 55.66% | 61.07% | 3.42% | 51.14% | 97.56% | 0.006 | 95 |

| F3Net (Group) | 72.51% | 77.95% | 2.08% | 67.78% | 98.38% | 0.035 | 20 |

| F3Net (Total) | 70.30% | 74.47% | 1.83% | 66.58% | 98.35% | 0.127 | 20 |

| U2Net (Group) | 71.89% | 75.63% | 2.07% | 68.49% | 98.57% | 0.012 | 25 |

| U2Net (Total) | 63.92% | 71.34% | 2.91% | 57.91% | 97.92% | 0.011 | 25 |

| GCPANet (Group) | 70.97% | 77.29% | 5.55% | 65.60% | 97.68% | 0.230 | 18 |

| GCPANet (Total) | 72.48% | 79.07% | 2.39% | 66.90% | 97.84% | 0.191 | 18 |

| SCWS (Group) | 72.96% | 81.49% | 10.26% | 66.05% | 91.35% | 0.102 | 20 |

| SCWS (Total) | 70.54% | 80.60% | 10.10% | 62.71% | 92.22% | 0.101 | 20 |

| DDNet (Group) | 70.11% | 76.03% | 3.96% | 65.04% | 98.52% | 0.013 | 19 |

| DDNet (Total) | 69.94% | 75.75% | 6.04% | 64.96% | 98.34% | 0.022 | 19 |

| RCSB (Group) | 71.74% | 80.75% | 2.79% | 64.55% | 98.99% | 0.008 | 74 |

| RCSB (Total) | 64.54% | 67.86% | 6.52% | 61.52% | 98.25% | 0.048 | 74 |

| WNet (Group) (Ours) | 74.16% | 79.60% | 2.05% | 69.42% | 99.07% | 0.013 | 23 |

| WNet (Total) | 70.62% | 76.62% | 2.16% | 65.49% | 98.80% | 0.010 | 23 |

表4 本文算法和对比方法在ZJU⁃Group 4上的定量实验结果的比较

Table 4

| 方法 | f | TPR | FPR | PPV | NPV | MAE | Time (ms) |

|---|---|---|---|---|---|---|---|

| PicaNet (Group) | 63.12% | 68.15% | 3.26% | 58.79% | 97.16% | 0.010 | 95 |

| PicaNet (Total) | 63.52% | 68.14% | 3.11% | 59.49% | 97.03% | 0.006 | 95 |

| F3Net (Group) | 73.95% | 79.06% | 2.36% | 69.46% | 98.01% | 0.044 | 21 |

| F3Net (Total) | 71.71% | 77.83% | 2.77% | 66.49% | 98.14% | 0.177 | 21 |

| U2Net (Group) | 73.66% | 78.88% | 2.76% | 69.09% | 98.28% | 0.012 | 26 |

| U2Net (Total) | 70.14% | 75.42% | 3.05% | 65.55% | 98.02% | 0.014 | 26 |

| GCPANet (Group) | 72.04% | 78.39% | 5.39% | 66.64% | 96.99% | 0.350 | 19 |

| GCPANet (Total) | 74.74% | 80.81% | 2.68% | 69.51% | 97.63% | 0.160 | 19 |

| SCWS (Group) | 71.17% | 86.32% | 9.76% | 60.55% | 93.42% | 0.033 | 21 |

| SCWS (Total) | 70.11% | 82.93% | 10.06% | 60.72% | 93.19% | 0.100 | 21 |

| DDNet (Group) | 72.76% | 78.81% | 4.88% | 67.57% | 98.28% | 0.024 | 20 |

| DDNet (Total) | 72.69% | 78.76% | 5.62% | 67.49% | 98.26% | 0.029 | 20 |

| RCSB (Group) | 71.47% | 74.57% | 3.85% | 68.62% | 98.53% | 0.018 | 78 |

| RCSB (Total) | 71.01% | 74.14% | 4.05% | 68.13% | 98.50% | 0.026 | 78 |

| WNet (Group) (Ours) | 74.86% | 78.16% | 2.22% | 71.84% | 98.45% | 0.014 | 25 |

| WNet (Total) | 73.50% | 76.10% | 2.20% | 71.08% | 98.26% | 0.013 | 25 |

许多方法对瑕疵边缘产生了大面积的误判,使TP(预测值和真实值同为正例)和FP(预测值为正例,真实值为负例)显著升高,一定程度上提高了TPR.高梯度纹理区域的误检也会提高FP,使NPV提升缓慢甚至下降.例如,SCWS和F3Net的TPR较高,NPV和fmeasure较低,尤其是MAE显著高于其他方法,说明这些方法在织物瑕疵区域和纹理区域产生了大量的错误判断.后续的定性比较实验也证实部分方法产生了大量的漏检和误检.

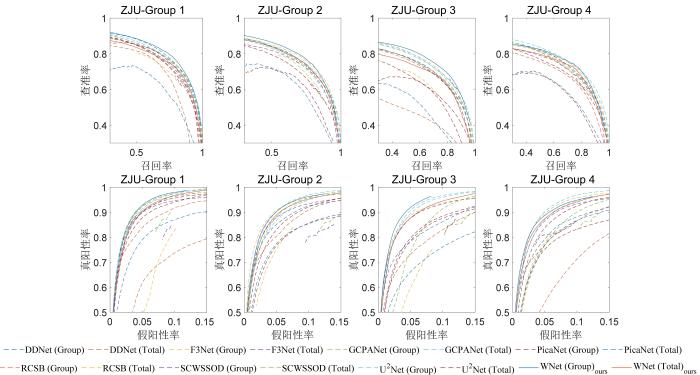

图7是本文方法和对比方法的PR曲线和ROC曲线.由图可见,WNet的曲线十分平滑,在大部分数据集中都涵盖了其他模型的曲线,说明WNet的结果更接近二元预测.值得注意的是,由于SCWS的输出特征加强模块过分增强了预测的置信度,所以其ROC曲线出现了过短的情况.

图7

图7

各个方法的PR曲线(上一行)和ROC曲线(下一行)对比

Fig.7

PR curves (up) and ROC curves (down) of each method

以

表5 各个方法的大小、运算量、参数量和泛化能力的对比

Table 5

| 方法 | GFLOPs | Params (M) | Size (M) | |

|---|---|---|---|---|

| WNet | 74.79% | 7.3 | 27.7 | 113 |

| PicaNet | 65.02% | 80.6 | 49.7 | 189 |

| F3Net | 73.80% | 6.7 | 25.5 | 97.8 |

| U2Net | 71.64% | 28.8 | 44 | 168 |

| GCPANet | 74.11% | 16.6 | 67.1 | 256 |

| SCWS | 71.33% | 21.8 | 63.5 | 242 |

| DDNet | 73.17% | 4.6 | 33.3 | 12.8 |

| RCSB | 71.31% | 218 | 33.5 | 137 |

由表可见,在保证模型泛化能力的基础上,WNet没有显著增加计算消耗,模型运算量和参数量都较低.与其他方法相比,WNet相对轻量化,模型保存也仅需113 M.对比其他方法,WNet的

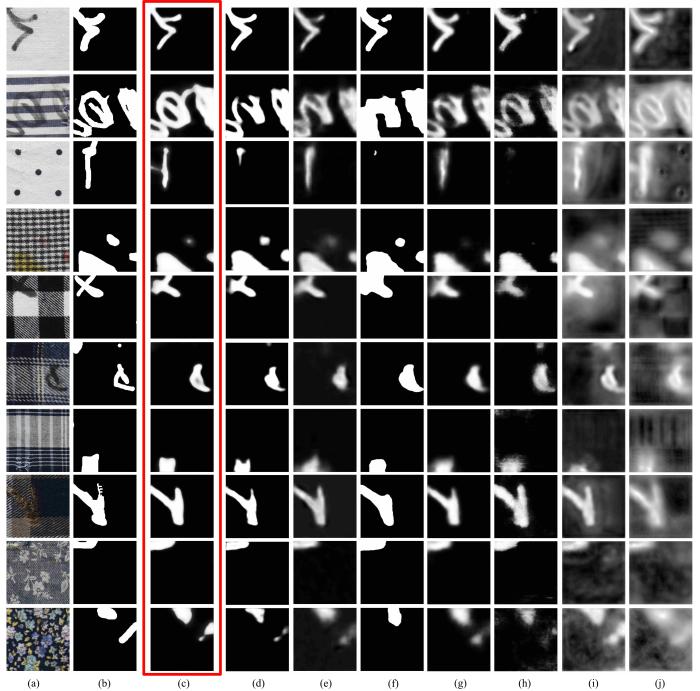

3.4 定性比较

可视化对比如图8所示.由图可见,F3Net和GCPANet尽管其TPR和PPV相对高于其他方法,但这两种方法出现了大规模的边缘模糊,也存在大规模的高梯度纹理区域的误判,造成其MAE显著高于其他方法.

图8

图8

WNet与其他方法的定性比较

(a) image,(b) GT,(c) WNet,(d) RCSB,(e) DDNet,(f) SCWS,(g) U2Net,(h) PicaNet,(i)F3Net,(j) GCPANet

Fig.8

Qualitative comparison of WNet with other methods

SCWS会强迫融合关联特征,它的预测图置信度过高.如图8中第二行和第六行所示,SCWS将大面积的瑕疵边缘纹理误判为瑕疵,一定程度上提高了TP进而影响了评价指标TPR.第三行中,低显著性褶皱类瑕疵与纹理的关联度很高,SCWS特征融合模块会过滤瑕疵特征,因此出现了大面积的漏检.

WNet比U2Net,DDNet,F3Net的边缘过渡更清晰,且预测置信度更高.与其他方法相比,WNet能充分过滤背景纹理特征,提取更多的织物细节特征.在第二行和第六行,WNet没有对无暇区域产生大面积误判.综上可见,WNet可以产生细节丰富的特征预测图.

3.5 消融实验

为了验证本文提出的双端输入、各个模块以及改进的损失函数的有效性,在ZJU⁃Group 4数据集上进行消融实验,表6展示了各个方法的定量比较,表中黑体字表示结果最优.其中,Bce和WgBce分别表示采用Bce Loss和WgBce Loss进行监督训练,R&S_Pret表示双路骨干网络载入预训练参数,NoPret表示骨干网络不载入预训练参数.在编码阶段,Res&ST表示使用双路骨干,+ASPP表示使用ASPP作为细节补充模块,+DB表示使用嵌套双分支作为细节补充模块.在解码阶段,ASPP和DB分别表示将ASPP和嵌套双分支模块作为解码模块,SBP代表使用单分支普通池化模块,验证嵌套双分支模块的分支有效性.由表可见,使用单个残差分支的fmeasure为68.19%,使用单个Swin Transformer分支的fmeasure为68.23%,对比双路分支的fmeasure,分别降低6.67%和6.63%,证明了本文双骨干分支的有效性.将WNet中的DBN模块改用ASPP替代初级特征提取模块和解码模块,fmeasure分别降低0.93%和1.93%.另外,U2Net使用WGBCE Loss的fmeasure提升0.36%,WNet使用WGBCE Loss的fmeasure提升0.79%,说明本文提出的WGBCE Loss损失函数是有效的.

表6 损失函数、DBN模块以及连接方式在ZJU⁃Group 4上的消融研究

Table 6

| 损失函数及预训练 | 编码阶段 | 解码阶段 | TPR | FPR | PPV | NPV | FPS (ms) | |

|---|---|---|---|---|---|---|---|---|

| Bce | U2Net | 73.66% | 78.88% | 2.76% | 69.09% | 98.28% | 26 | |

| WgBce | U2Net | 74.02% | 78.47% | 2.40% | 70.05% | 98.35% | 26 | |

| WgBce R&S_Pret | Res&ST+ASPP | DB | 73.93% | 78.36% | 2.52% | 69.97% | 98.54% | 27 |

| WgBce R&S_Pret | Res&ST+ASPP | ASPP | 73.56% | 77.30% | 2.37% | 70.18% | 98.45% | 24 |

| WgBce R&S_Pret | Res&ST+DB | ASPP | 72.93% | 73.53% | 2.00% | 72.34% | 98.22% | 24 |

| WgBce S_Pret | ST+DB | DB | 68.23% | 74.40% | 3.67% | 63.00% | 98.35% | 22 |

| WgBce R_Pret | Res+DB | DB | 68.19% | 73.02% | 3.17% | 63.97% | 98.26% | 18 |

| WgBce R&S_Pret | Res&ST | DB | 73.91% | 77.97% | 2.36% | 70.25% | 98.48% | 23 |

| WgBce No Pret | Res&ST+DB | DB | 69.90% | 75.11% | 3.41% | 65.36% | 98.37% | 24 |

| Bce R&S_Pret | Res&ST+DB | DB | 74.07% | 76.70% | 2.20% | 71.62% | 98.35% | 24 |

| WgBce R&S_Pret | Res&ST+SBP | SBP | 73.35% | 78.66% | 2.57% | 68.71% | 98.61% | 22 |

| WgBce R&S_Pret | Res&ST+DB | DB | 74.86% | 78.16% | 2.22% | 71.84% | 98.45% | 24 |

因为ZJU⁃Group 2中既有简单纹理类型的Dot Pattern纹理,也有类周期低对比度的Gingham纹理和Knot Pattern纹理,即ZJU⁃Group 2综合了Group 1和Group 3的纹理特征,所以在Group 2上进行了相同的模块消融实验,进一步验证算法模块的泛化有效性.实验结果如表7所示,表中黑体字表示结果最优.由表可见,Group 2上的实验结果与Group 4上的实验结果呈规律近似一致性,进一步说明本文的算法模块具备泛化能力.

表7 损失函数、DBN模块以及连接方式在ZJU⁃Group 2上的消融研究

Table 7

| 损失函数及预训练 | 编码阶段 | 解码阶段 | TPR | FPR | PPV | NPV | FPS (ms) | |

|---|---|---|---|---|---|---|---|---|

| WgBce R&S_Pret | Res&ST+ASPP | DB | 75.78% | 80.54% | 2.57% | 71.55% | 98.59% | 27 |

| WgBce R&S_Pret | Res&ST+ASPP | ASPP | 75.14% | 79.22% | 2.55% | 71.46% | 98.49% | 24 |

| WgBce R&S_Pret | Res&ST+DB | ASPP | 75.09% | 79.15% | 2.52% | 71.43% | 98.40% | 25 |

| WgBce S_Pret | ST+DB | DB | 71.82% | 74.92% | 2.66% | 68.96% | 98.05% | 22 |

| WgBce R_Pret | Res+DB | DB | 72.81% | 78.52% | 2.96% | 67.88% | 98.42% | 18 |

| WgBce R&S_Pret | Res&ST | DB | 75.21% | 77.66% | 2.09% | 72.91% | 98.12% | 23 |

| WgBce No Pret | Res&ST+DB | DB | 72.89% | 77.54% | 2.80% | 68.77% | 98.39% | 24 |

| Bce R&S_Pret | Res&ST+DB | DB | 76.14% | 80.14% | 2.67% | 72.52% | 98.50% | 24 |

| WgBce R&S_Pret | Res&ST+SBP | SBP | 75.29% | 79.81% | 2.69% | 71.25% | 98.53% | 22 |

| WgBce R&S_Pret | Res&ST+DB | DB | 76.66% | 79.34% | 2.29% | 74.16% | 98.45% | 24 |

最终实验使用的损失函数是WGBCE Loss,它包含两个超参数

图9

综合考量,选用的参数区间为

表 8 ZJU⁃Group 4上不同参数损失函数的消融实验

Table 8

| TPR | FPR | PPV | NPV | MAE | |||

|---|---|---|---|---|---|---|---|

| 0.1 | 0.05 | 71.13% | 76.10% | 2.69% | 66.77% | 98.45% | 0.012 |

| 0.1 | 74.50% | 77.29% | 2.16% | 71.90% | 98.39% | 0.010 | |

| 0.15 | 73.86% | 77.58% | 2.28% | 70.48% | 98.42% | 0.15 | |

| 0.2 | 73.80% | 77.92% | 2.42% | 70.09% | 98.46% | 0.013 | |

| 0.2 | 0.05 | 74.26% | 78.83% | 2.48% | 70.18% | 98.55% | 0.015 |

| 0.1 | 74.86% | 78.16% | 2.22% | 71.84% | 98.45% | 0.014 | |

| 0.15 | 74.19% | 77.46% | 2.27% | 71.18% | 98.37% | 0.012 | |

| 0.2 | 73.92% | 79.28% | 2.59% | 69.24% | 98.56% | 0.013 | |

| 0.3 | 0.05 | 73.10% | 74.63% | 2.03% | 71.63% | 98.32% | 0.015 |

| 0.1 | 73.73% | 78.60% | 2.62% | 69.42% | 98.60% | 0.012 | |

| 0.15 | 73.73% | 76.08% | 2.11% | 71.53% | 98.30% | 0.011 | |

| 0.2 | 73.74% | 74.54% | 2.01% | 72.96% | 98.25% | 0.016 |

4 结论

针对复杂纹理织物瑕疵检测,本文提出一种双端输入型嵌套融合多尺度信息的网络架构WNet.为了降低深层网络中背景特征对瑕疵特征的干扰,借助右骨干分支的全局建模能力,在卷积深层网络中补充全局上下文信息.为了减少深层网络中瑕疵细节信息丢失,提出一种轻量级双分支池化金字塔,将浅层多尺度细节特征引入深层模块.在特征融合阶段,为了进一步细化、筛选、增强输入特征,甄别高梯度纹理特征和瑕疵特征,利用嵌套DBPP实现多尺度嵌套双分支模块,该模块更关注多尺度不同感受野范围内的特征信息,可以生成更加精确的多阶段瑕疵预测图像.最后,为了降低高梯度纹理区域的误检率,对二元交叉熵损失函数进行了改进,以提高预测置信度.提出的方法在四个瑕疵测试集上的综合评价指标较优,尤其是fmeasure、阳性预测率和阴性预测率较高.但是,本文方法WNet的平均查准率依旧有较大的提升空间,同时,针对细小的织物瑕疵,检测效果依旧不够理想.

未来的研究将考虑改进特征融合方式,以更轻量高效的方式提高复杂纹理中瑕疵的检测精度.

参考文献

基于图像校正和模板分割的纺织品瑕疵检测

Fabric defect detection based on image correction and template segmentation

基于模板校正与低秩分解的纺织品瑕疵检测方法

Fabric defect detection based on template correction and low⁃rank decomposition

Fabric defect detection via low⁃rank decomposition with gradient information and structured graph algorithm

基于局部最优分析的纺织品瑕疵检测方法

Fabric defect detection based on local optimum analysis

基于畸变校正与视觉显著特征的纺织品瑕疵检测

Fabric defect detection based on distortion correction and visual salient features

Multistage GAN for fabric defect detection

Improved faster R⁃CNN for fabric defect detection based on Gabor filter with Genetic Algorithm optimization

Mobile⁃unet:An efficient convolutional neural network for fabric defect detection

Dropout:A simple way to prevent neural networks from overfitting

Deep residual learning for image recognition

∥

Densely connected convolutional networks

∥

Fully convolutional networks for semantic segmentation

∥

DeepLab:Semantic image segmentation with deep convolutional nets,atrous convolution,and fully connected CRFs

Encoder⁃decoder with atrous separable convolution for semantic image segmentation

∥

Attention is all you need

∥

An image is worth 16×16 words:Transformers for image recognition at scale

∥

Swin transformer:Hierarchical vision transformer using shifted windows

∥

Bi⁃directional object⁃context prioritization learning for saliency ranking

∥

Feature pyramid networks for object detection

∥

Deeply supervised salient object detection with short connections

∥

Pyramid scene parsing network

∥

Focal loss for dense object detection

∥

Contour⁃aware loss:Boundary⁃aware learning for salient object segmentation

F³Net:Fusion,feedback and focus for salient object detection

∥

Recursive contour⁃saliency blending network for accurate salient object detection

∥

Learning superpixels with segmentation⁃aware affinity loss

∥

Model level ensemble for facial action unit recognition at the 3rd ABAW challenge

∥

Holistically⁃nested edge detection

∥

U2⁃Net:Going deeper with nested U⁃structure for salient object detection

ZJU⁃Leaper:A benchmark dataset for fabric defect detection and a comparative study

Frequency⁃tuned salient region detection

∥

PiCANet:Learning pixel⁃wise contextual attention for saliency detection

∥

Global context⁃aware progressive aggregation network for salient object detection

∥

Structure⁃consistent weakly supervised salient object detection with local saliency coherence

∥

Densely deformable efficient salient object detection network